一、概述

flannel 是一个较简单的网络插件,其支持多种网络方案,可以使用 etcd 或者 k8s 作为存储,来实现 docker 或者 k8s 的网络。其支持的网络方案 backend 有:

- hostgw

- udp

- vxlan

- ipip

- ipsec

同时也支持了多家云厂商的网络环境:

- AliVPC

- AWS VPC

- GCE

下面会简单介绍 flannel 的工作原理,并主要就标准环境下的网络方案 backend 做分析。

二、flannel 网络方案

flannel 的部署文件中包含一个 configmap,其中包含 flannel cni 的配置文件,以及 flannel 需要的 cluster-cidr 和使用的 backend 配置。flannel 通过 daemonset 调度到每个节点上。flannel 的 pod 有一个 init 容器,负责将 configmap 中的 cni-conf.json 复制到宿主机上的 /etc/cni/net.d/10-flannel.conflist。之后 flanneld 启动,其拥有 NET_ADMIN 和NET_RAW 的 capabilities。

这里需要注意的是,如果你的默认路由对应的网卡不是 node 使用的网卡(比如使用 vagrant 部署 k8s 时,虚拟机的 eth0 是默认的 nat 网卡,但是不用在 k8s 集群中),应该使用 --iface=eth1 来指定使用的网卡。

flannel 会根据 cluster-cidr 来为每个 node 分配单独的子网,这样就能保证不同 node 上的 pod ip 不会冲突。然后根据配置文件中不同的 backend 来注册网络。下面就开始简单分析不同 backend 的工作原理。其中

- IPIP 和 VXLAN 类似,不过 VXLAN 封装的是二层的帧,IPIP 封装的是 IP 包。这里不做分析。

-

UDP 使用的很少,也不做分析。

-

IPSEC 关注的是通信安全方面。不是这里关注的重点。不做分析。

为了方便后续的描述,这里先列举出整个集群的概况:

cluster cidr: 172.10.0.0/16

master: 192.168.33.101,子网是 172.10.100.0/24

node1: 192.168.33.102,子网是 172.10.0.0/24

node2: 192.168.33.103,子网是 172.10.1.0/24

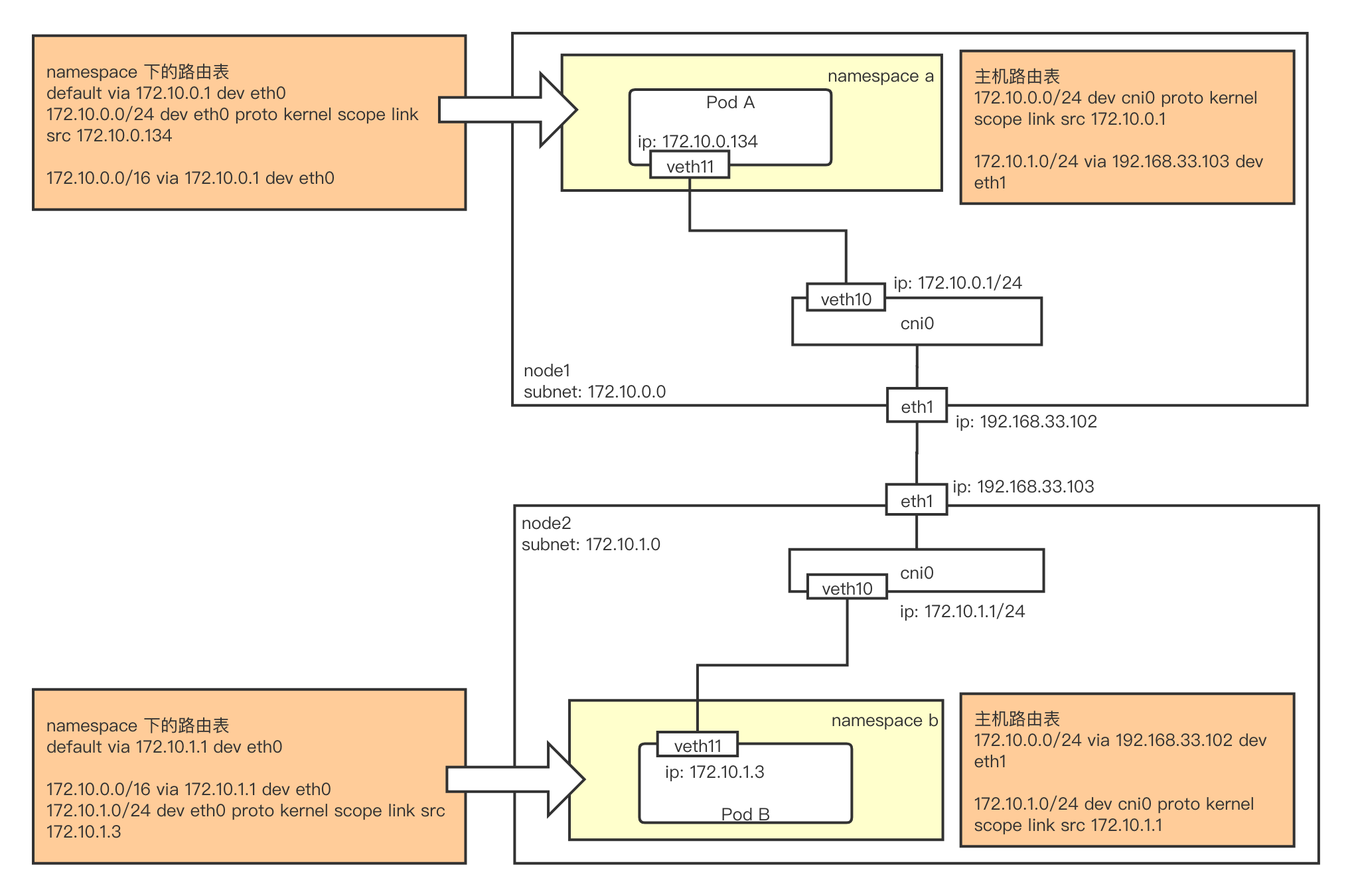

2.1 host-gw

host-gw 是最简单的 backend,所有的 pod 都会被接入到虚拟网桥 cni0 上,然后它通过监听 subnet 的更新,来动态的更新 host 上的路由表。通过路由来实现不同 node 上的 pod 间通信以及 node 和 pod 间的通信。如下图所示:

- Node1 上的 pod A(172.10.0.134) 和 node2 上的 pod B(172.10.1.3) 通信时,A 根据 namespace 下的路由规则

default via 172.10.0.1 dev eth0将流量发往网关 cni0 到达宿主机。 - 根据宿主机路由规则

172.10.1.0/24 via 192.168.33.103 dev eth1,通过网卡 eth1 发往 192.168.33.103 这个网关,而这个网关正好是 node2 的 eth1 网卡 ip。 - node2 此时扮演网关的角色,根据路由规则

172.10.1.0/24 dev cni0 proto kernel scope link src 172.10.1.1, 通过 cni0 发送。使用 arp 找到目标 ip 对应的 mac 地址。将二层的目标 mac 地址替换成 pod B 的 mac 地址。将二层的源 mac 地址替换成 cni0 的 mac 地址。 - cni0 是个 bridge 设备。根据 mac 表来将流量从对应端口发送到 pod B 中。

因为通信过程的第 2 步需要将其他 node 作为网关,因此 hostgw 需要所有 node 二层互通。

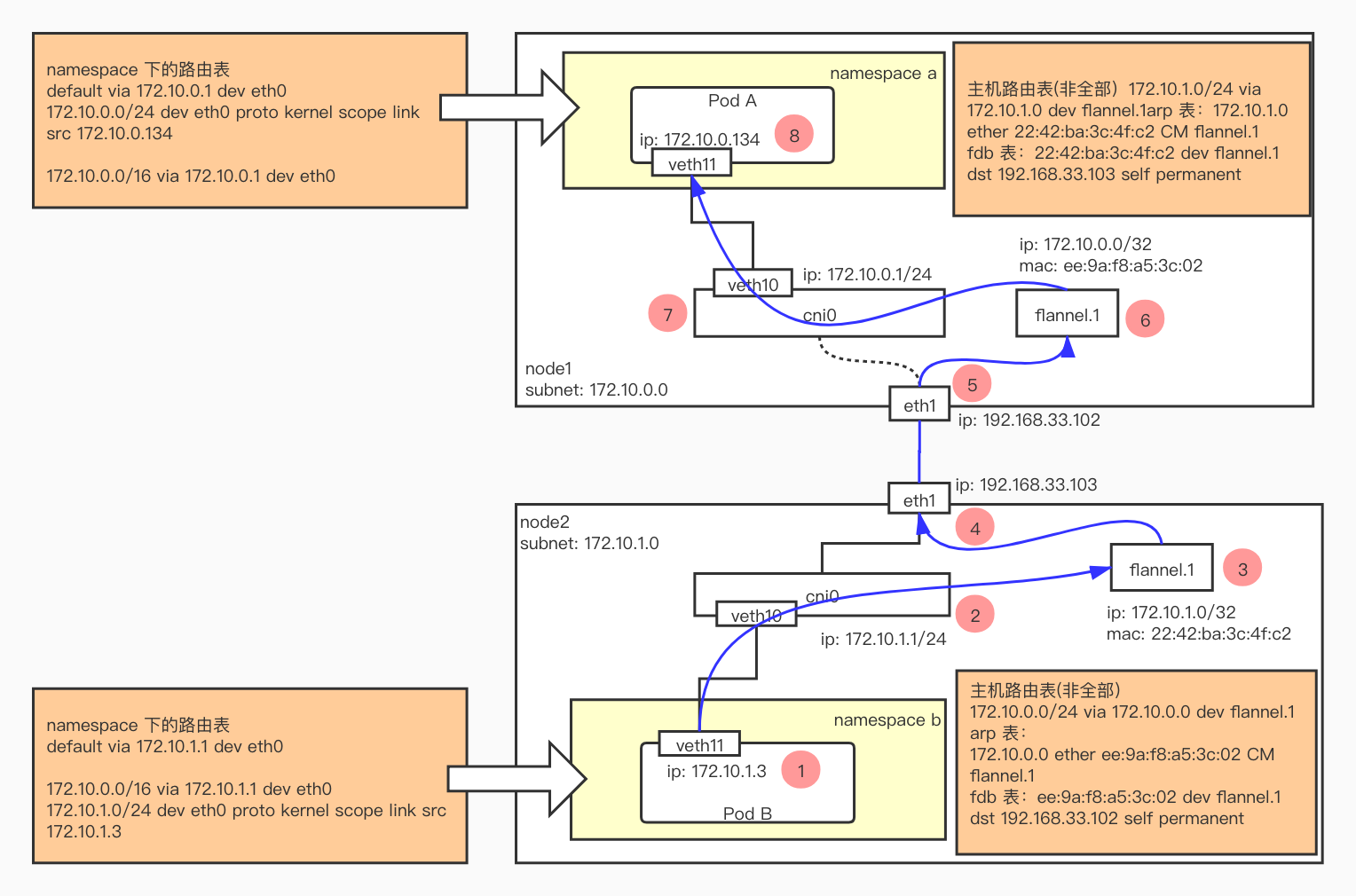

2.2 VXLAN

相比于 host-gw 必须要二层互通。VXLAN 是个 overlay 的网络实现,只需三层互通即可。在 flannel 的实现中,并没有使用 VXLAN 的全部能力,仅仅用它来做二层包的封装和解封装。其整个流程图如下:

可以发现,相比于 host-gw,增加了 flannel.1 这个设备。这个 flannel 的进程在启动的时候创建的。同时它还会监听所有的子网,每个节点加入网络中,都会创建一个属于自己的子网。flannel 进程在监听到新的子网创建时,会在当前节点创建以下:

- 一条路由:

172.10.0.0/24 via 172.10.0.0 dev flannel.1。172.10.0.0 的 IP 是其他节点的 flannel.1 地址。 - 一条 ARP:

172.10.0.0 ether ee:9a:f8:a5:3c:02 CM flannel.1。在包通过路由发出去前,需要知道 172.10.0.0 的二层地址。这时就会匹配这条 ARP 记录。 - 一条 FDB:

ee:9a:f8:a5:3c:02 dev flannel.1 dst 192.168.33.102 self permanent。这条 FDB 记录会匹配二层的转发路径。

为了更好的理解 flannel 的 vxlan 实现,我们按照图中的步骤一步步分析。

- Pod B (172.10.1.3) 向 Pod A (172.10.0.134) 发送数据。因为 Pod A 和 Pod B 的 IP 不在一个子网,因此走默认路由表,发向

172.10.1.1。这个地址是 cni0 的地址,因此可以直接发过去。 -

IP 包到达 cni0 网桥后,根据主机路由表

172.10.0.0/24 via 172.10.0.0 dev flannel.1,下一跳是 172.10.0.0,通过 flannel.1 发送。 -

此时需要知道 172.10.0.0 的 mac 地址,因此检查主机的 arp 表。发现

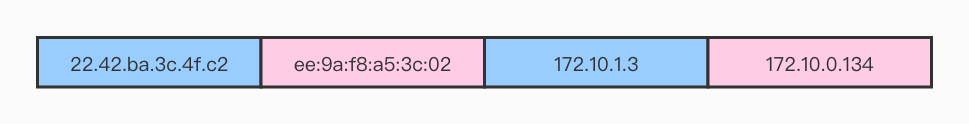

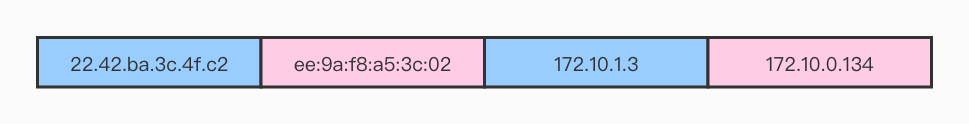

172.10.0.0 ether ee:9a:f8:a5:3c:02 CM flannel.1,因此要发送的帧如下:

-

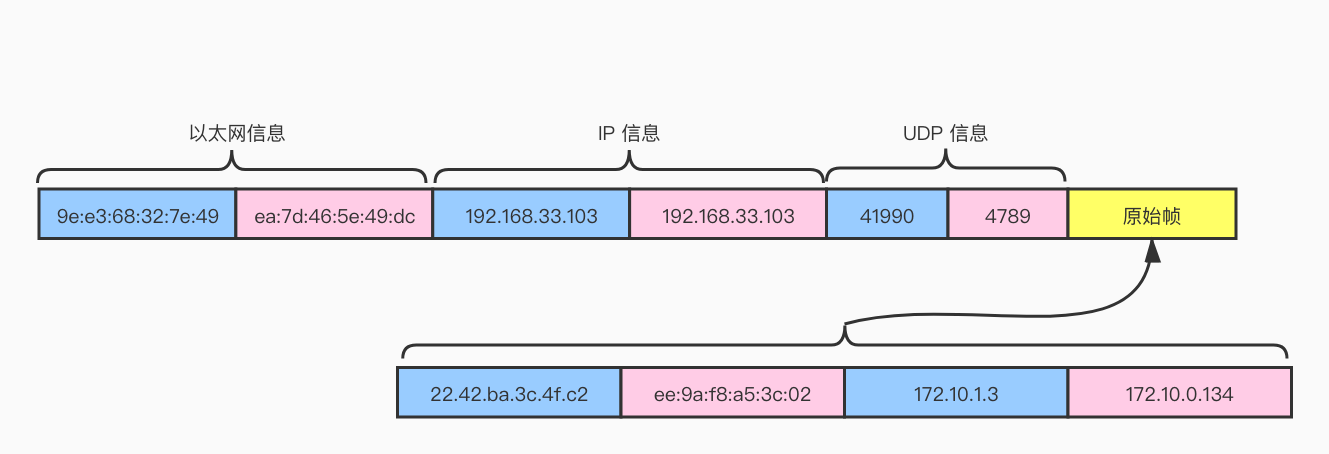

二层帧的转发需要查找主机的 fdb 表。这里匹配到

ee:9a:f8:a5:3c:02 dev flannel.1 dst 192.168.33.102 self permanent。封装成 vxlan 的包从 eth1 发出去。发出去的包如下:

-

对端的 eth1 网络收到包,发现是 vxlan,于是会对包解封装。二层地址是 flannel.1 设备的 mac 地址。因此发到 flannel.1 上。

-

此时三层目标地址是 172.10.0.134,因此匹配主机的路由表

172.10.0.0/24 dev cni0 proto kernel scope link src 172.10.0.1。这个路由表没有写在上图中。 -

cni0 和我们的 pod 是二层互通的。因此将包发给 pod。

-

pod 收到包。三层的来源地址是 172.10.1.3,二层的来源地址是 cni0 的 mac 地址。

可以通过以下命令行,模拟整个流程。

# host1

br0_ip="10.20.1.1"

vtep_ip="10.20.1.0/32"

endpoint_ip="10.20.1.4/24"

sudo ip link add name br0 type bridge forward_delay 1500 hello_time 200 max_age 2000 vlan_protocol 802.1Q

sudo ip addr add br0_ip/24 dev br0

sudo ip link add name vtep0 type vxlan id 1 dev ens33 srcport 0 0 dstport 4789 nolearning proxy ageing 300

sudo ip addr addvtep_ip dev vtep0

sudo ip link add name veth0 type veth peer name veth1

sudo ip netns add n1

sudo ip link set veth1 netns n1

sudo ip link set veth0 master br0

sudo ip netns exec n1 ip addr add endpoint_ip dev veth1

sudo ip netns exec n1 ip link set veth1 up

sudo ip netns exec n1 ip route add default viabr0_ip dev veth1

sudo ip link set veth0 up

sudo ip link set br0 up

sudo ip link set vtep0 up

# host2

br0_ip="10.20.2.1"

vtep_ip="10.20.2.0/32"

endpoint_ip="10.20.2.4/24"

sudo ip link add name br0 type bridge forward_delay 1500 hello_time 200 max_age 2000 vlan_protocol 802.1Q

sudo ip addr add br0_ip/24 dev br0

sudo ip link add name vtep0 type vxlan id 1 dev ens33 srcport 0 0 dstport 4789 nolearning proxy ageing 300

sudo ip addr addvtep_ip dev vtep0

sudo ip link add name veth0 type veth peer name veth1

sudo ip netns add n1

sudo ip link set veth1 netns n1

sudo ip link set veth0 master br0

sudo ip netns exec n1 ip addr add endpoint_ip dev veth1

sudo ip netns exec n1 ip link set veth1 up

sudo ip netns exec n1 ip route add default viabr0_ip dev veth1

sudo ip link set veth0 up

sudo ip link set br0 up

sudo ip link set vtep0 up

# host1

host2_vtep_mac="f2:a4:1f:4e:5c:51"

host2_vtep_ip="10.20.2.0"

subnet_mask="24"

host2_ip="192.168.105.167"

# one route

sudo ip route add host2_vtep_ip/subnet_mask via host2_vtep_ip dev vtep0 onlink

# one arp

sudo arp -i vtep0 -shost2_vtep_ip host2_vtep_mac

# one fdb

sudo bridge fdb addhost2_vtep_mac dev vtep0 dst host2_ip

# host2

host1_vtep_mac="be:ae:0d:f3:da:77"

host1_vtep_ip="10.20.1.0"

subnet_mask="24"

host1_ip="192.168.105.166"

# one route

sudo ip route addhost1_vtep_ip/subnet_mask viahost1_vtep_ip dev vtep0 onlink

# one arp

sudo arp -i vtep0 -s host1_vtep_iphost1_vtep_mac

# one fdb

sudo bridge fdb add host1_vtep_mac dev vtep0 dsthost1_ip

# host1 and host2

echo "1" > /proc/sys/net/ipv4/ip_forward

# host1

ip netns exec n1 ping 10.20.2.4